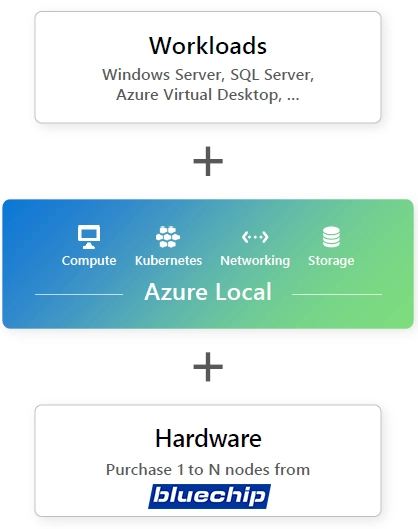

bluechip Azure Local Lösungen

Azure Local erweitert Azure auf kundeneigene Infrastruktur und ermöglicht die lokale Ausführung moderner und herkömmlicher Anwendungen an verteilten Standorten. Diese Lösung bietet eine einheitliche Verwaltungserfahrung auf einer einzigen Steuerungsebene und unterstützt eine breite Palette von validierter Hardware von vertrauenswürdigen Microsoft-Partnern.

Betrieb und Skalierung mit der Leistungsfähigkeit der Cloud

- Bereitstellung aus der Cloud

- Skalierung mit Infra-as-Code

- Aktualisierungen mit nur einem Klick

- Zentrale Sichtbarkeit

Bereit für all Ihre Apps: VMs und Container gleichermaßen

- Universelle VMs mit vollem Funktionsumfang

- Migrieren von VMware (in preview)

- AKS integriert und enthalten

- App-, Daten- und KI-Dienste (in preview)

Flexibilität, um Ihre Anforderungen und Ihr Budget zu erfüllen

- Wählen Sie Ihre Hardware

- Beschleunigen Sie Workloads mit GPUs

- Niedrige Spezifikationen, niedrige Kosten

- Getrennte Vorgänge (in preview)

Erweitern Sie die Cloud-Sicherheit auf Ihre verteilten Standorte

- Secure by default

- Microsoft Defender für Cloud

- Netzwerksicherheitsgruppen

- Vertrauenswürdiger Start

HIGHLIGHTS

- Skalierbarkeit

- Hohe Kosteneinsparungen

- Sicherheit

- Einfache Administration

- Top Performance

EINSATZGEBIETE

- Azure Virtual Desktop

- Ausführen von Azure Arc-Diensten vor Ort

- Leistungsstarker SQL Server

- Unternehmensvirtualisierung

- Zweigstelle und Edge

Typische Anwendungsfälle für Azure local

Azure Virtual Desktop (AVD)

Mit Azure Virtual Desktop für Azure Local können Sie Sitzungs-Hosts in Ihrer lokalen Infrastruktur bereitstellen und zentral über das Azure-Portal verwalten. Weitere Details finden Sie unter Azure Virtual Desktop für Azure Local.

Azure Kubernetes Service (AKS), aktiviert durch Azure Arc

Azure Local ermöglicht das Hosting containerbasierter Bereitstellungen, wodurch Workloaddichte und Ressourcennutzung optimiert werden. Zudem sorgt Azure Local für eine verbesserte Flexibilität und Ausfallsicherheit von Kubernetes-Deployments, indem es bei Hardwareausfällen ein automatisches Failover der Clusterknoten übernimmt. Dies ergänzt die Kubernetes-eigene Hochverfügbarkeit, die fehlerhafte Container neu startet. Weitere Informationen finden Sie unter Azure Kubernetes Service auf Azure Local und Windows Server.

Lokales Ausführen von Azure Arc-Diensten

Azure Arc ermöglicht den Einsatz von Azure-Diensten in jeder Umgebung – sei es in Azure, lokal, im Edge-Bereich oder bei anderen Cloud-Anbietern. Dadurch lassen sich hybride und Multi-Cloud-Architekturen einheitlich gestalten. Azure Arc-aktivierte Dienste unterstützen Arc-VMs, Azure-Datendienste und Anwendungsdienste wie Azure App Service, Functions, Logic Apps, Event Grid und API Management. Weitere Informationen finden Sie unter Übersicht über Azure Arc.

Hochleistungsfähige SQL Server-Instanzen

Azure Local bietet zusätzliche Ausfallsicherheit für geschäftskritische SQL Server-Bereitstellungen mit Always On-Verfügbarkeitsgruppen. Die Plattform optimiert Leistung und Support, indem sie eine tiefere Integration mit der zugrunde liegenden Infrastruktur ermöglicht. Weitere Informationen finden Sie unter Bereitstellen von SQL Server auf Azure Local.

Trusted Enterprise Virtualization

Azure Local erfüllt hohe Sicherheitsanforderungen durch integrierte Unterstützung für Virtualisierungsbasierte Sicherheit (VBS). Mithilfe von Hyper-V wird ein isolierter Speicherbereich innerhalb der Gast-VMs geschaffen, der sicherheitsrelevante Prozesse schützt und den Zugriff des Host-Betriebssystems darauf unterbindet. Dadurch wird die Anfälligkeit für Kernel-Exploits deutlich reduziert. Weitere Informationen finden Sie unter About Trusted Launch for Arc VMs on Azure Local.

Speicher für horizontales Skalieren

Die Kerntechnologie Storage Spaces Direct in Azure Local nutzt branchenübliche Server mit lokal angeschlossenen Laufwerken, um eine hohe Verfügbarkeit, Leistung und Skalierbarkeit zu gewährleisten. Im Vergleich zu herkömmlichen SAN- oder NAS-Lösungen bietet dieses Konzept erhebliche Kosteneinsparungen durch optimierte Speichertechnologien wie persistente Lese-/Schreib-Caches, beschleunigte Parität durch Spiegelung, geschachtelte Resilienz und Deduplizierung.

Notfallwiederherstellung für virtualisierte Workloads

Ein gestreckter Cluster von Azure Local (verfügbar ab Azure Stack HCI OS, Version 22H2) ermöglicht bei einem Ausfall des primären Standorts ein automatisches Failover von Workloads auf einen sekundären Standort. Eine synchrone Replikation sorgt für Absturzkonsistenz der VM-Datenträger.

Konsolidierung und Modernisierung von Rechenzentren

Durch die Aktualisierung und Konsolidierung älterer Virtualisierungshosts mit Azure Local lässt sich die Skalierbarkeit verbessern und die Verwaltung vereinfachen. Zudem können Legacy-SAN-Speicher außer Betrieb genommen und die Gesamtkosten reduziert werden. Einheitliche Verwaltungs-Tools und eine zentrale Support-Schnittstelle optimieren den Betrieb.

Filiale und Edge

Für Niederlassungen und Edge-Workloads können die Infrastrukturkosten durch den Einsatz von Zwei-Knoten-Clustern und kosteneffizienten Zeugenoptionen wie Cloud Witness oder Dateifreigabezeugen auf USB-Basis gesenkt werden. Der switchlose Netzwerkbetrieb zwischen Clusterknoten reduziert zusätzlich den Bedarf an teuren Hochgeschwindigkeitsswitches. Zudem lassen sich lokale Azure-Remotebereitstellungen zentral über das Azure-Portal verwalten.

Was geschieht mit Azure Stack HCI?

Azure Stack HCI ist jetzt Teil von Azure Local. Die gleichen Features

und Funktionalitäten werden unter dem neuen Namen weiterhin angeboten.

Für bestehende Kunden ist keine Aktion erforderlich. Im Vergleich zu

früheren Funktionen bietet Azure Local zusätzliche Flexibilität und

Features: Es unterstützt Hardware mit niedrigeren Spezifikationen (in

preview), getrennten Vorgängen (in preview), zusätzliche Dienste und

vieles mehr.

Was geschieht mit Azure Stack Hub und Azure Stack Edge?

Microsoft empfiehlt Azure Local für die meisten Situationen, in denen

eine Infrastruktur an verteilten Standorten benötigt wird. Sobald

Hardware mit niedrigeren Spezifikationen (in preview) und getrennten

Vorgängen (in preview) allgemein verfügbar sind, bietet Azure Local die

gleichen Funktionen wie frühere Azure Stack-Produkte. Bis dahin gibt es

keine Änderungen an Azure Stack Hub und Azure Stack Edge: Sie bleiben

als eigenständige Produkte verfügbar, getrennt von Azure Local.

Wird Azure Local von Microsoft verwaltet?

Nein, Sie sind Eigentümer der Hardware und haben die betriebliche

Kontrolle über Ihre lokale Azure-Umgebung. Die tägliche Überwachung,

Verwaltung, der Support und andere Funktionen werden über Azure-Tools

bereitgestellt, aber Aktionen werden vom Kunden initiiert. Wenn z. B.

ein Softwareupdate verfügbar ist, wird eine Benachrichtigung im

Azure-Portal angezeigt, aber Sie steuern, wann es angewendet wird.

Ist Azure Local ein Ersatz für VMware?

Azure Local ist nicht darauf ausgelegt, Rechenzentren zu ersetzen oder groß angelegte Migrationen von VMware zu unterstützen. Für die meisten VMware-Migrationen empfiehlt Microsoft die Verwendung von Azure VMware Solution, das den schnellsten und einfachsten Weg in die Cloud bietet und es IT-Administratoren ermöglicht, ihre vorhandenen VMware-Kenntnisse und -Abonnements zu nutzen.

Azure Local kann eine Option für bestimmte Anwendungsfälle sein, die dauerhaft lokal sind, insbesondere für Edge-Lösungen in Branchen wie Fertigung und Einzelhandel, in denen Kunden viele verteilte Standorte haben. Azure Local verwendet den Hyper-V-Hypervisor zum Ausführen von VMs und Azure Kubernetes Service mit AzureArc zum Ausführen von Containeranwendungen. Dies macht es zu einer praktikablen Lösung für Kunden mit lokalen VMware-Workloads in den oben genannten Szenarien, die sich ebenfalls von der VMware-Lizenzierung verabschieden möchten.

Überprüfen Sie die Netzwerk- und anderen Voraussetzungen und verwenden Sie bestenfalls validierte Azure Local Hardware von bluechip. Sie können die lokale Azure-Software über das Azure-Portal herunterladen und installieren. Nach der Installation stellt Azure Local eine Verbindung mit Azure her, um die tägliche Verwaltung zu ermöglichen. Azure Local wird automatisch über Ihr Azure-Abonnement abgerechnet – weitere Informationen erhalten Sie durch unser Consulting.